Los terremotos, sismos, seismos, temblores de tierra (del griego “σεισμός”, temblor), o temblor de tierra es una sacudida del terreno que se produce debido al choque de las placas tectónicas y a la liberación de energía en el curso de una reorganización brusca de materiales de la corteza terrestre al superar el estado de equilibrio mecánico son reajustes de la corteza terrestres causados por los movimientos de grandes fragmentos.

Los terremotos, sismos, seismos, temblores de tierra (del griego “σεισμός”, temblor), o temblor de tierra es una sacudida del terreno que se produce debido al choque de las placas tectónicas y a la liberación de energía en el curso de una reorganización brusca de materiales de la corteza terrestre al superar el estado de equilibrio mecánico son reajustes de la corteza terrestres causados por los movimientos de grandes fragmentos.

Dicho de otra manera, un sismo o temblor es un reajuste de la corteza terrestre causado por los movimientos vibratorios de las placas tectónicas del planeta y se propaga por él en todas direcciones en forma de ondas.

Por sí mismos, son fenómenos naturales que no afectan demasiado al hombre. El movimiento de la superficie terrestre que provoca un terremoto no representa un riesgo, salvo en casos excepcionales, pero sí nos afectan sus consecuencias, ocasionando catástrofes: caída de construcciones, incendio de ciudades, avalanchas y tsunamis.

Aunque todos los días se registran una buena cantidad de terremotos en el mundo, la inmensa mayoría son de poca magnitud. Sin embargo, se suelen producir dos o tres terremotos de gran intensidad cada año, con consecuencias imprevisibles.

Origen

La causa de los terremotos es la liberación de tención de las placas tectónicas.

La causa de un temblor es la liberación súbita de energía dentro del interior de la Tierra por un reacomodo de ésta. Este reacomodo se lleva a cabo mediante el movimiento relativo entre placas tectónicas. Las zonas en donde se lleva a cabo este tipo de movimiento se conocen como fallas geológicas (la falla de San Andrés es un ejemplo) y a los temblores producidos se les conoce como sismos tectónicos. No obstante existen otras causas que también producen temblores. Ejemplo de ello son los producidos por el ascenso de magma hacia la superficie de la Tierra. Este tipo de sismos, denominados volcánicos, nos pueden servir de aviso de una posible erupción volcánica.

Movimientos sísmicos

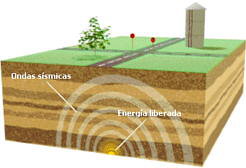

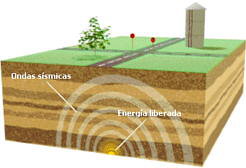

Las placas de la corteza terrestre están sometidas a tensiones. En la zona de roce (falla), la tensión es muy alta y, a veces, supera a la fuerza de sujeción entre las placas. Entonces, las placas se mueven violentamente, provocando ondulaciones y liberando una enorme cantidad de energía. Este proceso se llama movimiento sísmico o terremoto.

La intensidad o magnitud de un sismo, en la escala de Richter, representa la energía liberada y se mide en forma logarítmica, del uno al nueve. La ciencia que estudia los sismos es la sismologia y los científicos que la practican, sismólogos.

Aunque las actividades tectónica y volcánica son las principales causas por las que se generan los terremotos, existen otros muchos factores que pueden originarlos: desprendimientos de rocas en las laderas de las montañas y el hundimiento de cavernas, variaciones bruscas en la

presión atmosférica por

ciclones e incluso la actividad humana. Estos mecanismos generan eventos de baja magnitud que generalmente caen en el rango de microsismos, temblores que sólo pueden ser detectados por

sismógrafos.

Sismógrafo Vertical

La estadística sobre los sismos a través de la historia es más bien pobre. Se tiene información de desastres desde hace más de tres mil años, pero además de ser incompleta, los instrumentos de precisión para registrar sismos datan de principios del siglo XX y la Escala de Richter fue ideada en 1935.

Un terremoto de gran magnitud puede afectar más la superficie terrestre si el epifoco u origen del mismo se encuentra a menor profundidad. La destrucción de ciudades no depende únicamente de la magnitud del fenómeno, sino también de la distancia a que se encuentren del mismo, de la constitución geológica del subsuelo y de otros factores, entre los cuales hay que destacar las técnicas de construcción empleadas.

Los intentos de predecir cuándo y dónde se producirán los terremotos han tenido cierto éxito en los últimos años. En la actualidad, China, Japón, Rusia y Estados Unidos son los países que apoyan más estas investigaciones. En 1975, sismólogos chinos predijeron el sismo de magnitud 7,3 de Haicheng, y lograron evacuar a 90.000 residentes sólo dos días antes de que destruyera el 90% de los edificios de la ciudad. Una de las pistas que llevaron a esta predicción fue una serie de temblores de baja intensidad, llamados sacudidas precursoras, que empezaron a notarse cinco años antes.

Otras pistas potenciales son la inclinación o el pandeo de las superficies de tierra y los cambios en el campo magnético terrestre, en los niveles de agua de los pozos e incluso en el comportamiento de los animales. También hay un nuevo método en estudio basado en la medida del cambio de las tensiones sobre la corteza terrestre. Basándose en estos métodos, es posible pronosticar muchos terremotos, aunque estas predicciones no sean siempre acertadas.

Zonas del Terremoto

El punto interior de la

Tierra donde se produce el sismo se denomina foco sísmico o hipocentro, y el punto de la superficie que se halla directamente en la vertical del hipocentro —y que, por tanto, es el primer afectado por la sacudida— recibe el nombre de epicentro.

En un terremoto se distinguen:

hipocentro o foco, zona interior profunda, donde se produce el terremoto.

La probabilidad de ocurrencia de terremotos de una determinada magnitud en una región concreta viene dada por una

distribución de Poisson. Así la probabilidad de ocurrencia de k terremotos de magnitud M durante un período T en cierta región está dada por:

Donde:

Tr (M) es el

tiempo de retorno de un terremoto de intensidad M, que coincide con el tiempo medio entre dos terremotos de intensidad M.

Propagación

El movimiento sísmico se propaga mediante ondas elásticas (similares al sonido), a partir del hipocentro. Las ondas sísmicas se presentan en tres tipos principales:

Ondas de propagación producida por los terremotos

Ondas longitudinales, primarias o P: tipo de ondas de cuerpo que se propagan a una velocidad de entre 8 y 13 km/s y en el mismo sentido que la vibración de las partículas. Circulan por el interior de la Tierra, atravesando tanto líquidos como sólidos. Son las primeras que registran los aparatos de medida o sismógrafos, de ahí su nombre “P”.

Ondas transversales, secundarias o S: son ondas de cuerpo más lentas que las anteriores (entre 4 y 8 km/s) y se propagan perpendicularmente en el sentido de vibración de las partículas. Atraviesan únicamente los sólidos y se registran en segundo lugar en los aparatos de medida.

Ondas superficiales: son las más lentas de todas (3,5 km/s) y son producto de la interacción entre las ondas P y S a lo largo de la superficie de la Tierra. Son las que producen más daños. Se propagan a partir del epicentro y son similares a las ondas que se forman sobre la superficie del mar. Este tipo de ondas son las que se registran en último lugar en los sismógrafos.

Fallas Geológicas

Uno de los accidentes del terreno que se puede observar más fácilmente son las fallas o rupturas de un plegamiento, especialmente si el terreno es de tipo sefimentario.

Falla de San Andrés; pasa a través de California Estados Unidos y Baja California, México.

Las fallas son un tipo de deformación de la corteza terrestre que finaliza en ruptura, dando lugar a una gran variedad de estructuras geológicas.

Cuando esta ruptura se produce de forma brusca, se produce un terremoto. En ocasiones, la línea de falla permite que, en ciertos puntos, aflore el magma de las capas inferiores y se forme un volcán.

Partes de una falla

El plano de falla es la superficie sobre la que se ha producido el movimiento, horizontal, vertical u oblicuo. Si las fracturas son frágiles, tienen superficies lisas y pulidas por efecto de la abrasión. Durante el desplazamiento de las rocas fracturadas se pueden desprender fragmentos de diferentes tamaños.

Los labios de falla son los dos bordes o bloques que se han desplazado. Cuando se produce un desplazamiento vertical, los bordes reciben los nombres de labio hundido (o interior) y labio elevado (o superior), dependiendo de la ubicación de cada uno de ellos con respecto a la horizontal relativa. Cuando está inclinado, uno de los bloques se desliza sobre el otro. El bloque que queda por encima del plano de falla se llama “techo” y el que queda por debajo, “muro”.

El salto de falla es la distancia vertical entre dos estratos que originalmente formaban una unidad, medida entre los bordes del bloque elevado y el hundido. Esta distancia puede ser de tan sólo unos pocos milímetros (cuando se produce la ruptura), hasta varios kilómetros. Éste último caso suele ser resultado de un largo proceso geológico en el tiempo.

Tipos de fallas

En una falla normal, producida por tensiones, la inclinación del plano de falla coincide con la dirección del labio hundido. El resultado es un estiramiento o alargamiento de los materiales, al desplazarse el labio hundido por efecto de la fuerza de la gravedad.

En las fallas de desgarre, además del movimiento ascendente también se desplazan los bloques horizontalmente. Si pasa tiempo suficiente, la erosión puede allanar las paredes destruyendo cualquier traza de ruptura, pero si el movimiento es reciente o muy grande, puede dejar una cicatriz visible o un escarpe de falla con forma de precipicio. Un ejemplo especial de este tipo de fallas son aquellas transformadoras que desplazan a las dorsales oceánicas.

En una falla inversa, producida por las fuerzas que comprimen la corteza terrestre, el labio hundido en la falla normal, asciende sobre el plano de falla y, de esta forma, las rocas de los estratos más antiguos aparecen colocadas sobre los estratos más modernos, dando lugar así a los cabalgamientos.

Las fallas de rotación o de tijera se forman por efecto del basculado de los bloques sobre el plano de falla, es decir, un bloque presenta movimiento de rotación con respecto al otro. Mientras que una parte del plano de falla aparenta una falla normal, en la otra parece una falla inversa.

Un macizo tectónico o pilar tectónico, también llamado “Horst”, es una región elevada limitada por dos fallas normales, paralelas. Puede ocurrir que a los lados del horst haya series de fallas normales; en este caso, las vertientes de las montañas estarán formadas por una sucesión de niveles escalonados. En general, los macizos tectónicos son cadenas montañosas alargadas, que no aparecen aisladas, sino que están asociadas a fosas tectónicas. Por ejemlo, el centro de la península Ibérica está ocupada por los macizos tectónicos que forman las sierras de Gredos y Guadarrama.

Por último, una fosa tectónica o Graben es una asociación de fallas que da lugar a una región deprimida entre dos bloques levantados. Las fosas tectónicas se producen en áreas en las que se agrupan al menos dos fallas normales. Las fosas forman valles que pueden medir decenas de kilómetros de ancho y varios miles de kilómetros de longitud. Los valles se rellenan con sedimentos que pueden alcanzar cientos de metros de espesor. Así sucede, por ejemplo, en el valle del río Tajo, en la península Ibérica.

Terremotos marinos (Tsunamis)

Un maremoto es una invasión súbita de la franja costera por las aguas oceánicas debido a un tsunami, una gran ola marítima originada por un temblor de tierra submarino. Cuando esto ocurre, suele causar graves daños en el área afectada.

Los maremotos son más comunes en los litorales de los océanos Pacífico e Índico, en las zonas sísmicamente activas.

Los términos maremoto y tsunami se consideran sinónimos.

Tsunamis

Un TSUNAMI (del japonés TSU: puerto o bahía, NAMI: ola) es una ola o serie de olas que se producen en una masa de agua al ser empujada violentamente por una fuerza que la desplaza verticalmente. Este término fue adoptado en un congreso de 1963.

Los terremotos submarinos provocan movimientos del agua del mar (maremotos o tsunamis). Los tsunamis son olas enormes con longitudes de onda de hasta 100 kilómetros que viajan a velocidades de 700 a 1000 km/h. En alta mar la altura de la ola es pequeña, sin superar el metro; pero cuando llegan a la costa, al rodar sobre el fondo marino alcanzan alturas mucho mayores, de hasta 30 y más metros.

El tsunami está formado por varias olas que llegan separadas entre sí unos 15 o 20 minutos. La primera que llega no suele ser la más alta, sino que es muy parecida a las normales. Después se produce un impresionante descenso del nivel del mar seguido por la primera ola gigantesca y a continuación por varias más.

La falsa seguridad que suele dar el descenso del nivel del mar ha ocasionado muchas víctimas entre las personas que, imprudentemente, se acercan por curiosidad u otros motivos, a la línea de costa.

España puede sufrir tsunamis catastróficos, como quedó comprobado en el terremoto de Lisboa en 1755. Como consecuencia de este sismo varias grandes olas arrasaron el golfo de Cádiz causando más de 2.000 muertos y muchos heridos.

En 1946 se creó la red de alerta de tsunamis después del maremoto que arrasó la ciudad de Hilo (Hawaii) y varios puertos más del Pacífico. Hawaii es afectado por un tsunami catastrófico cada 25 años, aproximadamente, y EEUU, junto con otros países, han puesto estaciones de vigilancia y detectores que avisan de la aparición de olas producidas por sismos.

Terremotos, volcanes, meteoritos, derrumbes costeros o subterráneos e incluso explosiones de gran magnitud pueden generar un TSUNAMI.

Antiguamente se les llamaba marejadas, maremotos u ondas sísmicas marina, pero estos términos han ido quedando obsoletos, ya que no describen adecuadamente el fenómeno. Los dos primeros implican movimientos de marea, que es un fenómeno diferente y que tiene que ver con un desbalance oceánico provocado por la atracción gravitacional ejercida por los planetas, el sol y especialmente la luna. Las ondas sísmicas, por otra parte, implican un terremoto y ya vimos que hay varias otras causas de un TSUNAMI.

Un tsunami generalmente no es sentido por las naves en alta mar (las olas en alta mar son pequeñas) ni puede visualizarse desde la altura de un avión volando sobre el mar.

Como puede suponerse, los tsunamis pueden ser ocasionados por terremotos locales o por terremotos ocurridos a distancia. De ambos, los primeros son los que producen daños más devastadores debido a que no se alcanza a contar con tiempo suficiente para evacuar la zona (generalmente se producen entre 10 y 20 minutos después del terremoto) y a que el terremoto por sí mismo genera terror y caos que hacen muy difícil organizar una evacuación ordenada.

Causas de los Tsunamis

Como se mencionaba en el punto anterior, los Terremotos son la gran causa de tsunamis. Para que un terremoto origine un tsunami el fondo marino debe ser movido abruptamente en sentido vertical, de modo que el océano es impulsado fuera de su equilibrio normal. Cuando esta inmensa masa de agua trata de recuperar su equilibrio, se generan las olas. El tamaño del tsunami estará determinado por la magnitud de la deformación vertical del fondo marino. No todos los terremotos generan tsunamis, sino sólo aquellos de magnitud considerable, que ocurren bajo el lecho marino y que son capaces de deformarlo.

Si bien cualquier océano puede experimentar un tsunami, es más frecuente que ocurran en el Océano Pacífico, cuyas márgenes son más comúnmente asiento de terremotos de magnitudes considerables (especialmente las costas de Chile y Perú y Japón). Además el tipo de falla que ocurre entre las placas de Nazca y Sudamericana, llamada de subducción, esto es que una placa se va deslizando bajo la otra, hacen más propicia la deformidad del fondo marino y por ende los tsunamis.

A pesar de lo dicho anteriormente, se han reportado tsunamis devastadores en los Océanos Atlánticos e Indico, así como el Mar Mediterráneo. Un gran tsunami acompañó los terremotos de Lisboa en 1755, el del Paso de Mona de Puerto Rico en 1918, y el de Grand Banks de Canadá en 1929.

Las avalanchas, erupciones volcánicas y explosiones submarinas pueden ocasionar tsunamis que suelen disiparse rápidamente, sin alcanzar a provocar daños en sus márgenes continentales.

Respecto de los meteoritos, no hay antecedentes confiables acerca de su ocurrencia, pero la onda expansiva que provocarían al entrar al océano o el impacto en el fondo marino en caso de caer en zona de baja profundidad, son factores bastante sustentables como para pensar en ellos como eventual causa de tsunami, especialmente si se trata de un meteorito de gran tamaño.

Características físicas de un tsunami

Debido a la gran longitud de onda estas olas siempre “sienten” el fondo (son refractadas), ya que la profundidad siempre es inferior a la mitad de la longitud de onda (valor crítico que separa las olas de agua profunda de las olas de aguas someras). En consecuencia, en todo punto del océano, la velocidad de propagación del tsunami depende de la profundidad oceánica y puede ser calculado en función de ella.

Formación de un tsunami

En donde V es la velocidad de propagación, g la aceleración de gravedad (9.81 m /seg2) y d la profundidad del fondo marino. Para el Océano Pacífico la profundidad media es de 4.000 m, lo que da una velocidad de propagación promedio de 198 m/s ó 713 km/h. De este modo, si la profundidad de las aguas disminuye, la velocidad del tsunami decrece.

Cuando las profundidades son muy grandes, la onda de tsunami puede alcanzar gran velocidad, por ejemplo el tsunami del 4 de Noviembre de 1952 originado por un terremoto ocurrido en Petropavlosk (Kamchatka), demoró 20 horas y 40 minutos en llegar a Valparaíso en el otro extremo del Pacífico, a una distancia de 8348 millas, avanzando a una velocidad media de 404 nudos. La altura de la ola al llegar a la costa es variable, en el caso señalado en Talcahuano se registraron olas de 3.6 metros; en Sitka (Alaska) de 0.30 metros y en California de 1 metro.

Al aproximarse a las aguas bajas, las olas sufren fenómenos de refracción y disminuyen su velocidad y longitud de onda, aumentando su altura. En mares profundos éstas ondas pueden pasar inadvertidas ya que sólo tiene amplitudes que bordean el metro; sin embargo al llegar a la costa pueden excepcionalmente alcanzar hasta 20 metros de altura.

Es posible trazar cartas de propagación de tsunamis, como se hace con las cartas de olas; la diferencia es que los tsunamis son refractados en todas partes por las variaciones de profundidad; mientras que con las olas ocurre sólo cerca de la costa.

Sus características difieren notablemente de las olas generadas por el viento. Toda onda tiene un efecto orbital que alcanza una profundidad igual a la mitad de su longitud de onda; así una ola generada por el viento sólo en grandes tormentas puede alcanzar unos 300 metros de longitud de onda, lo cual indica que ejercerá efecto hasta 150 metros de profundidad.

Los tsunamis tienen normalmente longitudes de onda que superan los 50 kilómetros y pueden alcanzar hasta 1000 kilómetros, en tal caso el efecto orbital es constante y vigoroso en cualquier parte del fondo marino, ya que no existen profundidades semejantes en los océanos.

Parámetros físicos y geométricos de la onda de tsunami

La longitud de onda (L) de un tsunami corresponde al producto entre la velocidad de propagación (V) y el período (T), relación dada por:

L = V x T

de este modo, para una velocidad de propagación V = 713 km/h, y un período T = 15 minutos, la longitud de onda es L = 178 km. Debido a su gran longitud onda, el desplazamiento de un tsunami a grandes profundidades se manifiesta en la superficie oceánica con amplitudes tan solo de unos pocos centímetros

Las olas generadas por los vientos tienen períodos por lo general de menos de 15 segundos, a diferencia de las ondas de tsunami que oscilan entre 20 y 60 minutos. Esta característica permite diferenciarlas claramente en un registro mareográfico y por lo tanto advertir la presencia de un tsunami.

La altura de la ola H corresponde a la diferencia de nivel entre cresta y valle. Por otra parte, la cota máxima de inundación R, corresponde al lugar de la costa donde los efectos del tsunami son máximos.

Poder Destructivo de un Tsunami

La fuerza destructiva del tsunami en áreas costeras, depende de la combinación de los siguientes factores:

•Magnitud del fenómeno que lo induce. En el caso de ser un sismo submarino se debe considerar la magnitud y profundidad de su foco. •Influencia de la topografía submarina en la propagación del tsunami.

•Distancia a la costa desde el punto donde ocurrió el fenómeno (epicentro).

•Configuración de la línea de costa.

•Influencia de la orientación del eje de una bahía respecto al epicentro (características direccionales).

•Presencia o ausencia de corales o rompeolas, y el estado de la marea al tiempo de la llegada del tsunami.

•Influencia de la topografía en superficie, incluye pendientes y grado de rugosidad derivado de construcciones, arboles y otros obstáculos en tierra.

Efectos en la costa.

La llegada de un tsunami a las costas se manifiesta por un cambio anómalo en el nivel del mar, generalmente se presenta un aumento o recogimiento previo de las aguas; esta última situación suele dejar descubiertas grandes extensiones del fondo marino. Posteriormente, se produce una sucesión rápida y acentuada de ascensos y descensos del nivel de las aguas, cuya altura puede variar entre uno y cuatro metros; sin embargo, se han registrado casos puntuales en que las olas alcanzaron alturas superiores a los

Secuencia que muestra el estacionamiento del acuarium de Japón, antes, durante y después del tsunami de 1983.

Tsunami de Japón 2011

La ola de un tsunami acumula gran cantidad de energía; cuando llega a la línea costera, esta ola avanza sobre la tierra alcanzando alturas importantes sobre el nivel medio del mar. La ola y el flujo que le sigue, cuando encuentran un obstáculo descargan su energía impactando con gran fuerza. La dinámica de un tsunami en tierra es bastante compleja y normalmente no predecible; esto se debe a que influyen factores muy diversos como son: el período, la altura de la ola, la topografía submarina y terrestre determinando daños de diversa intensidad.

Los efectos de un tsunami son diferentes dependiendo de la duración del período. Con corto período, la ola llega a tierra con una fuerte corriente, y con período largo, se produce una inundación lenta con poca corriente. Por otra parte, mientras mayor sea la altura de la ola, mayor es la energía acumulada; por lo tanto, y dependiendo de la pendiente y morfología del terreno, mayor será la extensión de las áreas inundadas. Al respecto, estudios japoneses han determinado que mientras menor es la pendiente de la ola (razón entre la altura y la longitud de onda) mayor será la altura máxima de inundación.

Por otra parte, las variaciones en las formas y las pendientes de la batimetría submarina cercana a la línea de costa influye directamente en el potencial de energía del tsunami, ocurriendo amplificación o atenuación de las ondas.

Así, una costa en peldaños que tenga una plataforma continental escalonada con bruscos cambios de pendiente, hará que la onda de tsunami pierda gradualmente su energía cinética y por tanto potencial, lo anterior debido a los choques sucesivos de la masa de agua con el fondo marino. Las olas van disipando su energía en las paredes con los cambios bruscos de profundidad.

En tanto, una costa con topografía de pendientes suaves en forma de rampas en que la plataforma continental penetra suavemente en el mar, permitirá que la energía del tsunami sea transmitida en su totalidad, y por lo tanto, se incrementa el poder destructivo del mismo. Estas son costas de alto riesgo con olas de gran altura que producen inundación. En este caso la pérdida de energía es sólo por roce.

En las bahías puede haber reflexión en los bordes de las costas; en este caso si el período es igual (o múltiplo entero) al tiempo que demora en recorrer la bahía, al llegar la segunda ola puede verse reforzada con un remanente de la primera y aumentar la energía al interior de la bahía, este es el fenómeno de resonancia. Esta condición puede producir la amplificación de las alturas del tsunami al interior de una bahía como ocurre en la bahía de Concepción (SHOA, 1995).

La figura complementaria muestra la forma rectangular de la bahía con 14, 6 kilómetros de largo por 11,7 kilómetros de ancho, con una profundidad media de 25 metros. En 25 metros de profundidad la velocidad del tsunami es de 15,6 m/segundos o bien 56,3 km/hora, lo que significa que este recorre el largo de la bahía en 15,5 minutos y el ancho en 12,5 segundos.

La topografía de las tierras emergidas influye directamente en la penetración del tsunami en superficie. Cuando la pendiente es relativamente fuerte la extensión de la zona inundada no es significativa, en cambio, cuando el terreno es plano o con escasa pendiente, la penetración puede abarcar kilómetros tierras adentro.

En una falla normal, producida por tensiones, la inclinación del plano de falla coincide con la dirección del labio hundido. El resultado es un estiramiento o alargamiento de los materiales, al desplazarse el labio hundido por efecto de la fuerza de la gravedad.

En una falla normal, producida por tensiones, la inclinación del plano de falla coincide con la dirección del labio hundido. El resultado es un estiramiento o alargamiento de los materiales, al desplazarse el labio hundido por efecto de la fuerza de la gravedad. Los terremotos submarinos provocan movimientos del agua del mar (maremotos o tsunamis). Los tsunamis son olas enormes con longitudes de onda de hasta 100 kilómetros que viajan a velocidades de 700 a 1000 km/h. En alta mar la altura de la ola es pequeña, sin superar el metro; pero cuando llegan a la costa, al rodar sobre el fondo marino alcanzan alturas mucho mayores, de hasta 30 y más metros.

Los terremotos submarinos provocan movimientos del agua del mar (maremotos o tsunamis). Los tsunamis son olas enormes con longitudes de onda de hasta 100 kilómetros que viajan a velocidades de 700 a 1000 km/h. En alta mar la altura de la ola es pequeña, sin superar el metro; pero cuando llegan a la costa, al rodar sobre el fondo marino alcanzan alturas mucho mayores, de hasta 30 y más metros.